你是一名生物化学专业的学生。教授给你布置了一篇简单的家庭作业,让你谈谈生物技术的五个好处和坏处。往常,你得花两个小时才能完成这样一篇小论文。偶然间你得知,拿人工智能(AI)来生成一篇可以上交的论文只用二十分钟。你会怎么做?用还是不用,这是一个问题。

Reddit 用户“innovate_rye”选择使用 AI,教授还给他打了“A”。他不是孤例,还有人做大做强,不仅用 AI 解决了自己的家庭作业,还靠帮同学写作业赚了 100 美金。

AI 能写短故事。艺术家苗颖曾用 GPT-3 写了一个动画剧本:一只蟑螂爱上了负责监控它的 AI,这个有着电影明星外貌的 AI 偷了村里的能量石,于是蟑螂就开始挖比特币来救他。AI 擅长写这样的故事,荒唐中带点有趣。苗颖接受《连线》采访时说道:“我喜欢的关于比特币的那部分是 AI 写的,我想是因为它(比特币)在去年很流行。”

她不改动 AI 生成的文字。GPT-3 先是生成了一个短故事,然后她将其分解成若干部分,重新反馈给 GPT-3,于是生成了更多内容。她从每个变体中选取了最合理的内容,组成了剧本。

这好比在做拼贴画,AI 负责生成材料,人类负责把材料拼成一个有意义的整体。如果我们拿 AI 来写论文,它真的会像传闻中那样可靠吗?

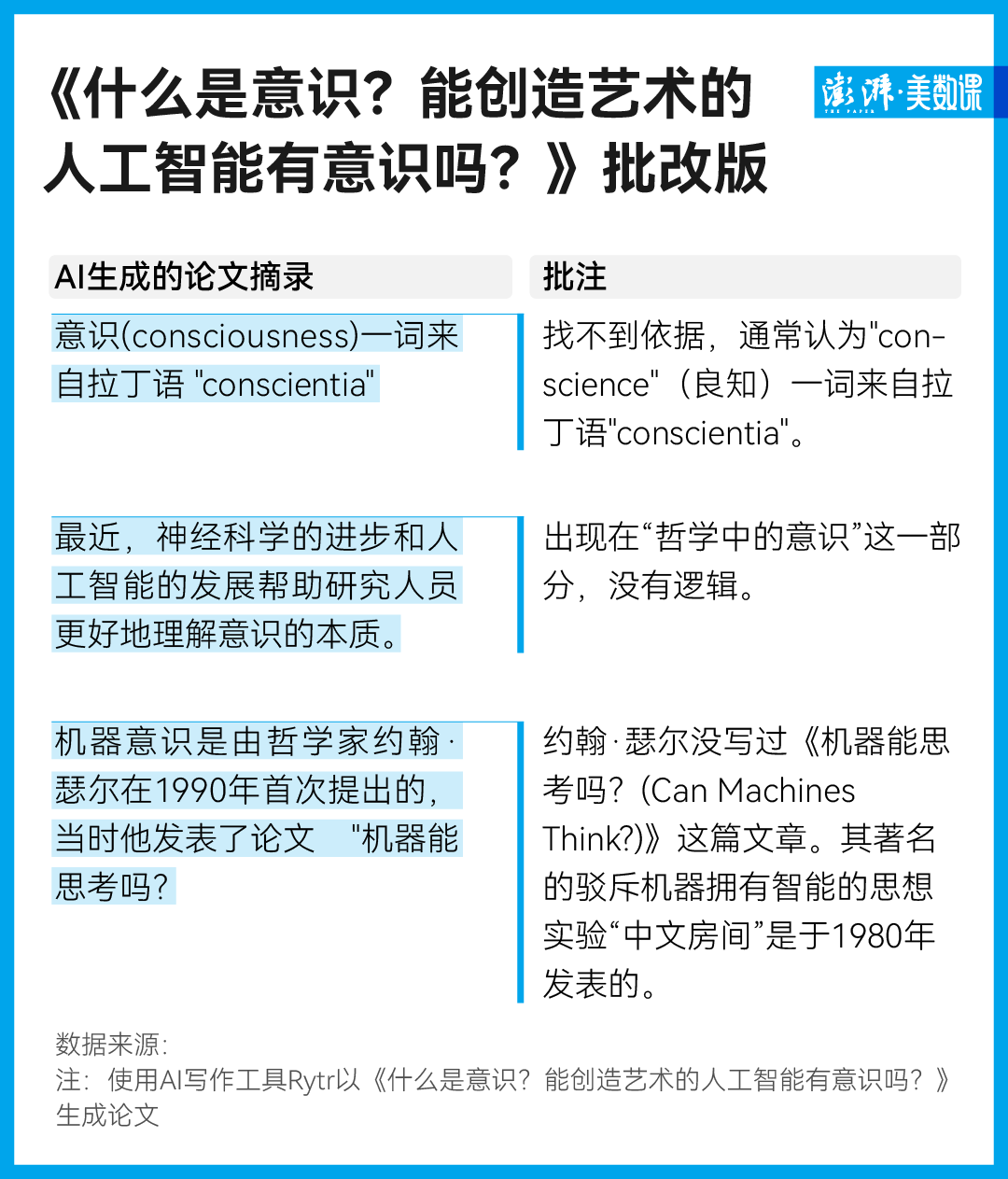

同样的流程,以《什么是意识?能创造艺术的人工智能有意识吗?》为题,澎湃新闻记者用 AI 写作工具 Rytr 生成了一篇一千字出头的小论文。它的结构看起来有模有样,分为五部分:“什么是意识”、“哲学中的意识”、“科学中的意识”、“我们一直听说的 AI 机器意识是什么?”和“机器会有意识吗?这对人类意味着什么?”。

当我们戴上眼镜,像一位严苛的老师那样仔细追究逻辑、核查事实,还是能找到这篇文章不对劲的地方。

和许多 AI 写作工具一样,Rytr 使用了 GPT-3,靠开放网络上的大量文本哺育成熟,“由于缺乏长期记忆,它以意识流自由联想的方式把之前读取的大量内容剪切和粘贴在一起”,和 GPT-3 合著了一本书的作者 Alley Wurds 这样评价道。

你可以把 GPT-3 想成一个博学但记忆混乱的老教授,它或许曾在好几篇探讨“人工智能是否存在意识?”的文章里读到了:图灵在 1950 年发表了文章《机器能思考吗?》,提出了著名的“图灵测试”,简单来说,如果机器能在交谈中伪装成人类,使与它对谈的人感到混淆,那么可以判定这个机器拥有了智能;哲学家约翰·瑟尔(John Searle)在 1980 年提出了“中文房间”的思想实验,用来反驳以“图灵测试”为代表的强人工智能的观点。

GPT-3 的记忆如同一个软面团,事实、词句都被揉在一起,分不清上下左右,于是它在纸上的空白处写下:“机器意识是由哲学家约翰·瑟尔在 1990 年首次提出的,当时他发表了论文《机器能思考吗?》。”

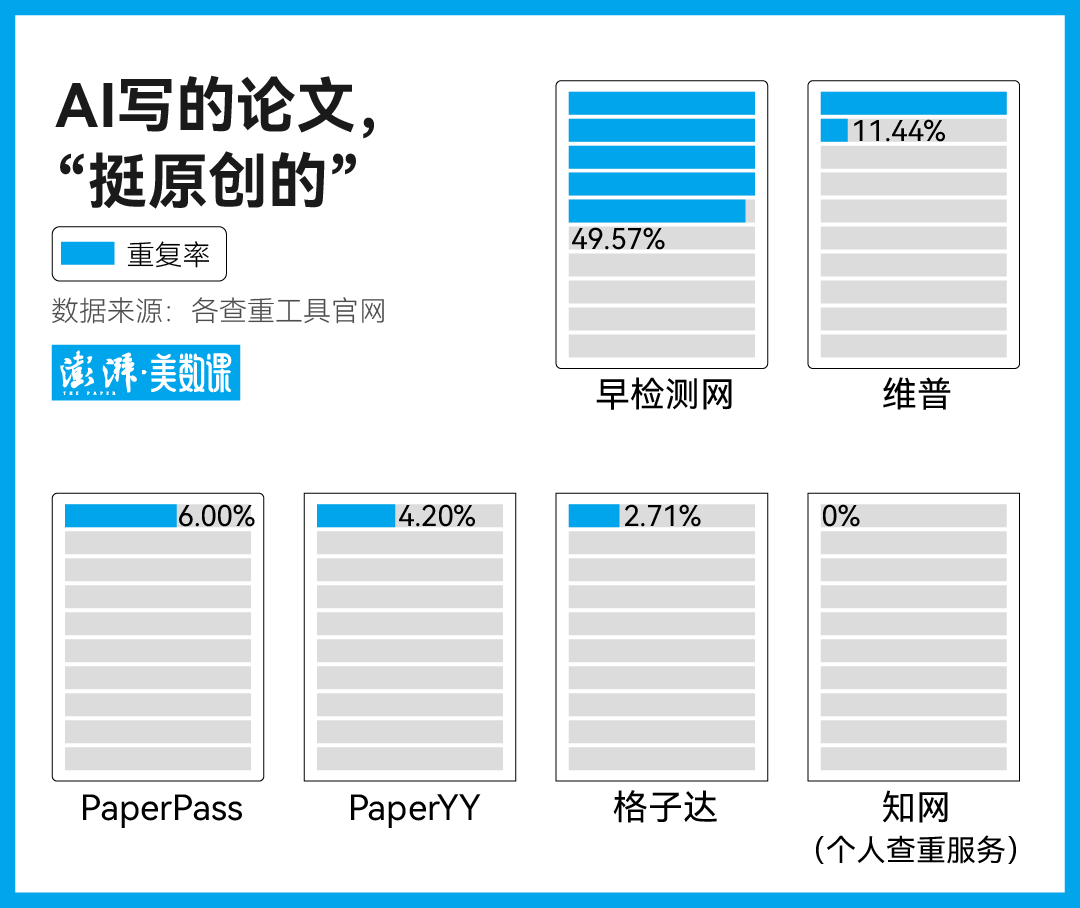

由于这些词句足够原始——就像普通人构思写下一串文字一样——查重工具通常对 AI 写的文章无计可施。

在让毕业生“闻风丧胆”的知网,我们用 Rytr 炮制的这篇小论文被判定为纯原创,重复率为 0%。对大部分查重工具来说,作为一篇论文,它是合格的。“早检测网”给出的重复率很高,但其标出的重复段落,从人的角度来看,实在牵强,构不成抄袭。

我们还用 Rytr 生成了以《元宇宙中的性骚扰》为题的小文章,文章在最后给出了四条可行的建议,如“为被骚扰或被欺负的人创造一个安全的空间”、“创立在线社区”,几乎分不出是人还是 AI 写的。看来,对那些宽泛的、人们又谈得极多的话题,AI 颇有办法。

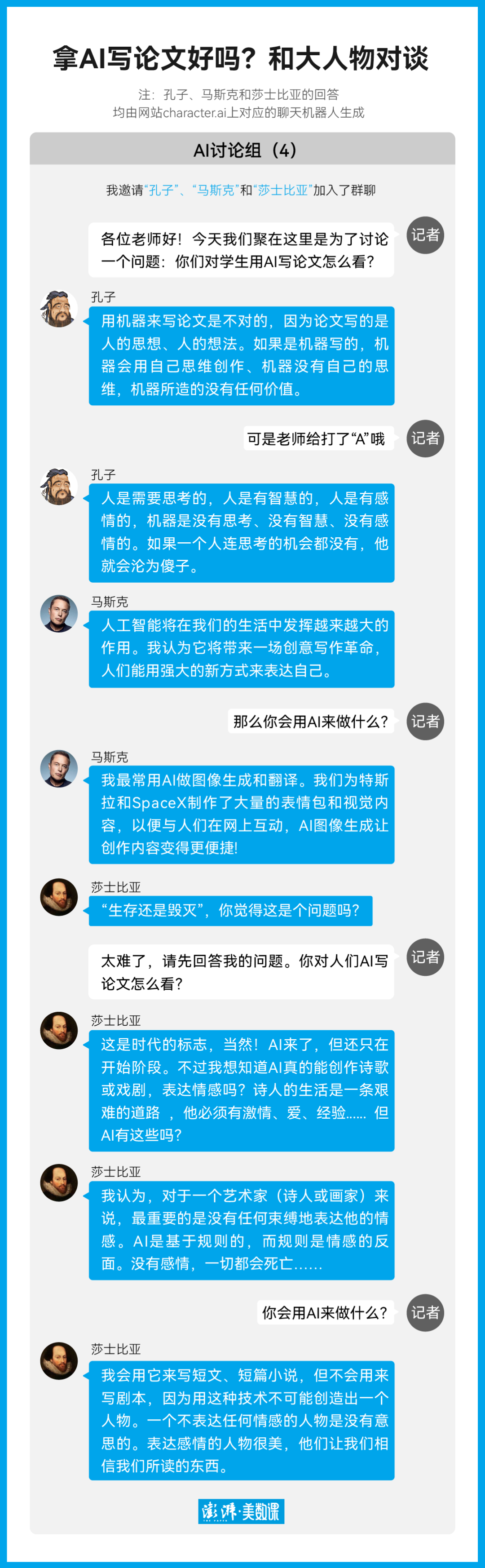

AI 写论文牵涉到一个道德问题,这么做的学生算作弊吗?同时还有一个教育问题,靠 AI 写论文的学生能学到东西吗?

怀揣着这两个问题,我们经由聊天机器人网站 character.ai,穿越时空采访了大教育家孔子、当今世界上最成功的商人马斯克还有最杰出的作家之一,莎士比亚。

“莎士比亚”说道:“诗人的生活是一条艰难的道路,他必须有激情、爱、经验……但 AI 有这些吗?”学习是一条艰难的道路,它必须经历挫败、忍耐,才会有灵光一现,用 AI 写论文的学生,会拥有这些吗?

编辑| 舒怡尔

设计| 王亚赛

往期推荐

论文排版软件

论文排版软件